这个叫 Spider_XHS 的小红书爬虫神器,已经在 GitHub 上获得 3000 多 Star 了。它不仅是一个爬虫工具,更是一套小红书全域运营的解决方案。

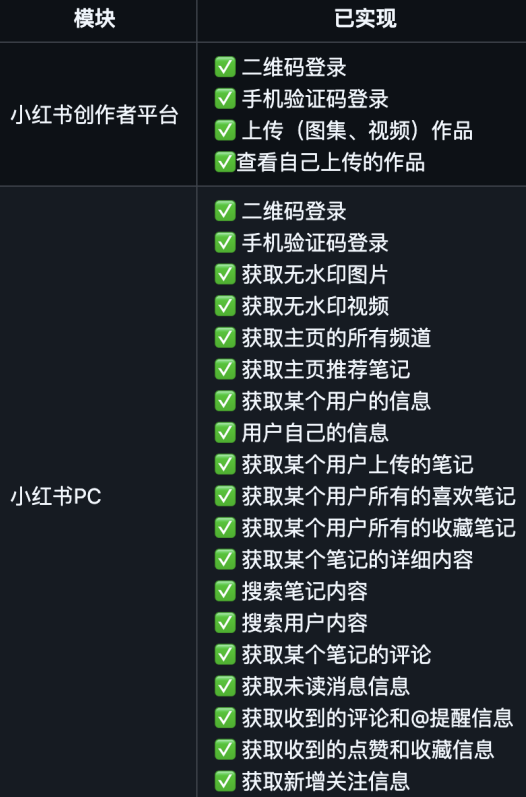

这个开源的小红书数据采集开源项目支持多种维度的数据抓取,能够将数据保存为 Excel 表格或直接下载多媒体文件。

某个用户所有的小红书笔记,能保存到本地文件夹:每一个笔记都是按照如下这种方式保存,能自动提取并下载高清无水印图片,还能保存笔记链接、标题、点赞/收藏数据等等。

除了爬之外,它还集成了创作者平台的接口,支持笔记的自动化上传,简直是运营人的效率倍增器。

使用该项目需要具备基础的 Python 和 Node.js 环境。

# 下载项目

git clone https://github.com/cv-cat/Spider_XHS.git

cd Spider_XHS

# 安装 Python 依赖

pip install -r requirements.txt

# 安装 Node.js 依赖(用于加密参数生成)

npm install

这是最关键的一步。项目根目录有一个 .env 文件,如果没有则新建一个,你需要将自己的小红书 Cookie 填入其中。

① 浏览器打开小红书网页版并登录。

② 按 F12 打开开发者工具,找到 Network (网络) 选项卡。

③ 刷新页面,随便点击一个请求,在 Request Headers 中找到 cookie 字段。

④ 将 Cookie 复制并粘贴到 .env 文件中。

入口是 main.py,你可以根据需求修改代码中的调用逻辑,然后直接运行:python main.py运行后,你会在控制台看到采集进度,采集到的数据和媒体文件会自动保存在相应的文件夹中。

开源地址:https://github.com/cv-cat/Spider_XHS